【我們想讓你知道】

隨著生成式AI應用快速爆發,全球雲端服務供應商不再依賴輝達(Nvidia)單一供應來源,而是積極投入自研晶片,而ASIC晶片正成為降低算力成本、掌握控制權的核心關鍵。

撰文:韭菜叔叔

在生成式AI浪潮下,算力成為科技業的核心戰場。過去兩年,GPU(圖形處理器)幾乎與AI畫上等號,特別是輝達(Nvidia)的H100,不僅價格昂貴,更供不應求,成為CSP(雲端服務供應商)擴建資料中心的關鍵瓶頸。

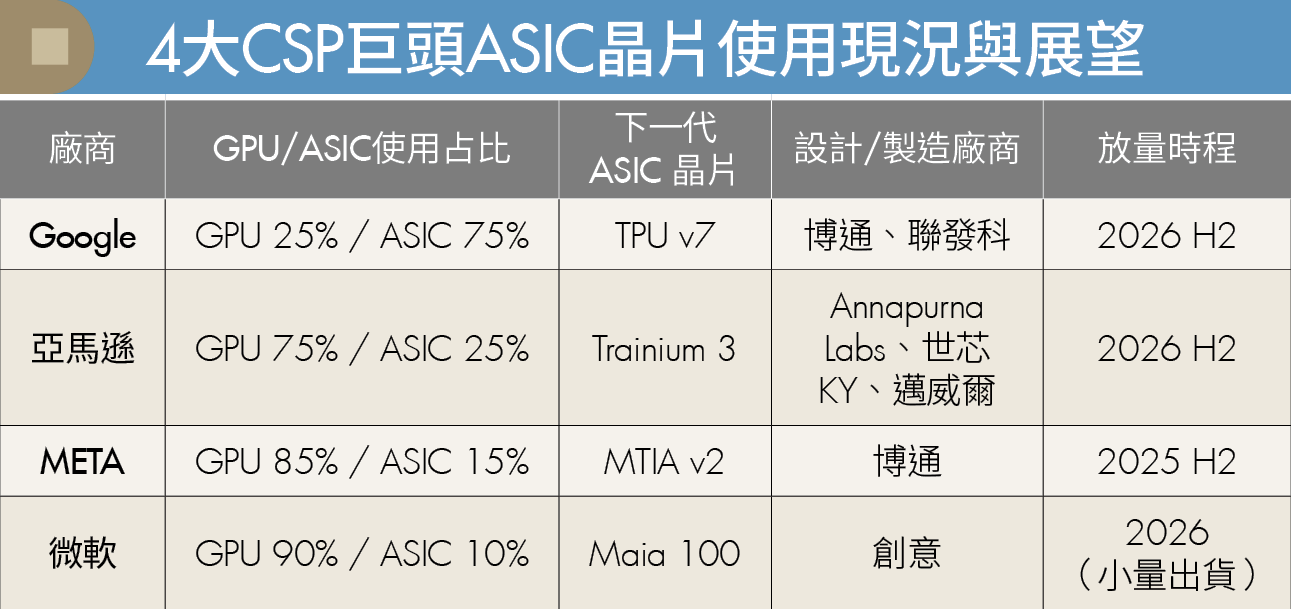

為打破瓶頸、壓低成本,Google、亞馬遜(Amazon)、META與微軟(Microsoft)等科技巨頭正積極投入自研ASIC(特定應用積體電路),啟動「去GPU化」行動,打造自主算力生態系。

算力戰火燒向晶片自主權 CSP加速自研ASIC

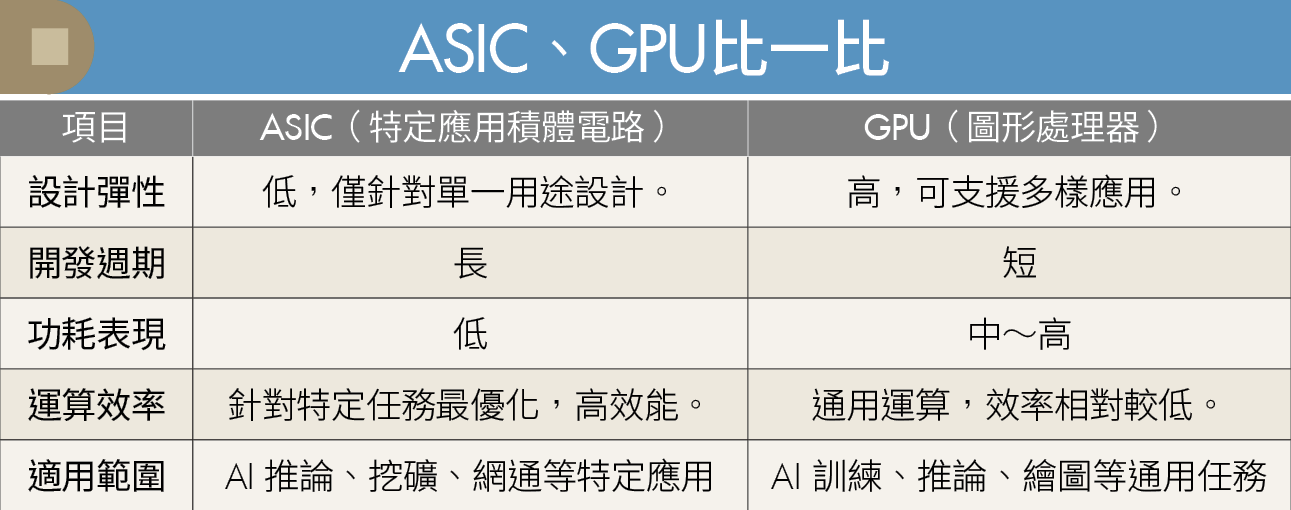

要理解這場轉變,先得認識ASIC。這類晶片針對單一任務量身打造,適用AI推論、挖礦、網通等應用,具備低功耗、高效率等優勢。雖然彈性差、開發週期長,但在資料中心大量部署時,能有效降低能源與營運成本。

相對來說,CPU(中央處理器)是通用型晶片,具高彈性與穩定性,但功耗與效率皆不及專用晶片;GPU則擅長平行運算,適合AI訓練與推論,但耗電高、成本重。CSP若要大規模布建AI運算能力,自研ASIC便成了理想解方。

CSP自研ASIC背後有著4大戰略考量。首先是成本,自製晶片價格約為輝達高階GPU的10分之1,節省空間巨大。其次是模型最佳化,可依自家模型客製硬體架構,提升效能與能源效率。第三是降低能源與散熱壓力,有助於建構更高密度的資料中心。最後是建立自有平台優勢,例如Google TPU on GCP、AWS Trainium on EC2,提供具差異化的雲端服務。

4大CSP巨頭陷激戰 引發供應鏈格局重塑

發表

發表

我的網誌

我的網誌